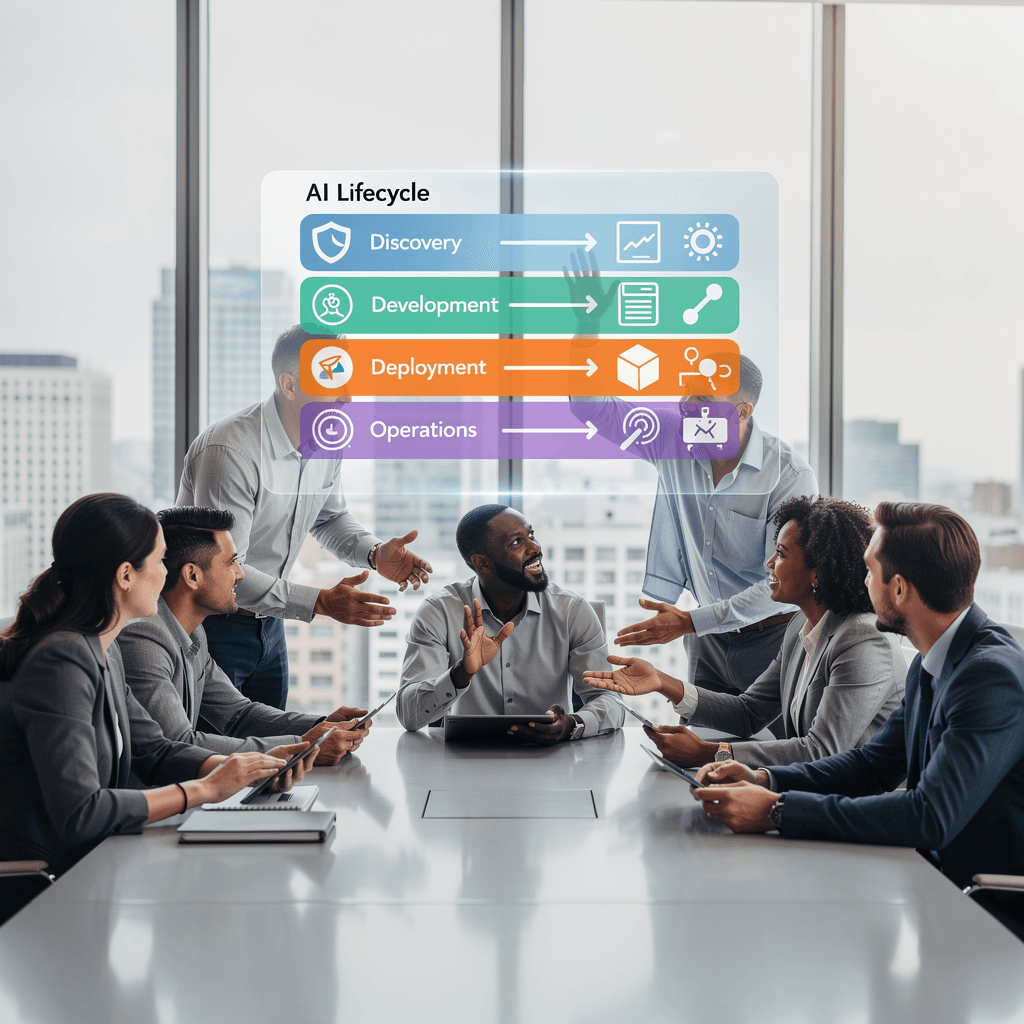

당신의 조직에서 AI를 다루는 책임의 그림은 어디까지 명확합니까? 데이터가 말하는 대로 움직이더라도, 그 말에 누가 최종 책임을 지는가가 애매하다면 결국 의사결정은 느려지고 리스크는 축적됩니다. 오늘의 고민은 바로 여기에 있습니다. AI 시스템의 수명주기가 길어지면서, 발견-개발-배포-운영-감사의 각 단계에 누가 어떤 권한으로 관여할지가 뚜렷해야만 비즈니스 목표와의 정렬이 지속될 수 있습니다. 이 글은 중소기업이 실무적으로 적용할 수 있는 AI 운영팀의 역할 매핑과 책임 정의 프레임프워크를 탐구합니다.

왜 이 프레임이 필요한가

- 거버넌스가 단순한 이념이 아니라 실제 의사결정의 표준이 되어야 한다는 점은 더 이상 비즈니스 전략의 선택지가 아닙니다. 대기업과 중견기업의 사례를 보면, 이사회 차원의 RA(I) 거버넌스 도입과 전사 운영 모델 정비가 동시에 진행되면서 책임의 경계가 선명해지고 있습니다. 최근 연구에서도 거버넌스 성숙도가 AI 의사결정의 신뢰성과 직결된다고 봅니다.

- 예: McKinsey의 2024 연구 및 사례들은 AI 거버넌스의 체계화가 기업 운영의 핵심 과제로 자리매김하고 있음을 보여줍니다. 또한 미국 NIST의 AI RMF, ARIA 프로그램, ISO 42001의 표준이 점차 실무에 반영되고 있습니다.

-

참고: McKinsey(2024), NIST AI RMF(1.0), ISO 42001, EU AI Act 등

-

이 포럼의 초점은 규정의 충족 그 자체가 아니라, 어떻게 운영의 흐름 속에서 “누가 어떤 결정을 언제 어떻게 내리는지”를 명확히 기록하고 공유하는가에 있습니다. 이를 통해 데이터 품질, 모델 위험, 개인정보 보호, 그리고 규제 준수 여부를 하나의 연결고리로 관리하는 체계를 구축합니다.

핵심 구성 요소 네 축에서 설계하기

이 프레임의 핵심은 아래 네 가지 축이 서로를 보완하며 작동하는 구조입니다. 각각의 축은 실무에서 바로 사용할 수 있는 산출물과 프로세스를 포함합니다.

- 거버넌스와 정책(정책 수립과 의사결정 기록의 체계화)

- 암묵적 합의가 아니라, 누가, 무엇을, 언제 승인하고 기록하는지에 대한 명확한 규칙을 만듭니다. RA(I) 관점의 역할 정의가 여기에 속합니다. 규제 요구와 윤리 원칙도 함께 반영합니다.

-

실무 포인트: AI 시스템 목록화, 정책 문서화, 감사 로그의 표준화.

-

리스크 관리(위험 식별·평가·감사 체계)

- NIST의 AI RMF와 ARIA 같은 프레임워크를 바탕으로 위험을 체계적으로 평가하고, 이를 비즈니스 의사결정에 연결합니다. 고위험 영역의 평가 주기와 감사 포맷을 미리 정의합니다.

-

실무 포인트: 위험 평가 양식, 모델 위험 관리 체크리스트, 컴플라이언스 맵(데이터 흐름과 처리의 투명성 확보).

-

운영 관리(데이터/모델의 생애주기 관리)

- ISO 42001의 AI 관리 시스템(AIMS)을 참고해 데이터 흐름, 모델 문서화, 운영(runbook) 등을 연결합니다. 실무로 들어가면, 데이터 소유자, 피처 엔지니어, 모델 개발자, 운영 엔지니어 간의 책임 분담이 구체화됩니다.

-

실무 포인트: 모델 인벤토리, 데이터 품질 지표, 자동화된 모니터링 스펙, 로그와 사고 후 학습 체계.

-

실행/생태계(현장 운영과 협업의 실제)

- AIOps 관점에서 IT 운영과 AI 운영의 융합이 가속화되고 있습니다. Human-in-the-loop(HITL) 관점으로 인간의 검토가 필요할 때를 명확히 정의하고, 자동화된 대응과 빠른 사고 대응 흐름을 설계합니다.

- 실무 포인트: runbook, 사고 대응 절차, 공급망 관리 및 계약상 책임의 명시.

모든 축은 서로를 참조하며 하나의 운영 모델로 연결됩니다. 예를 들어, 데이터 품질 문제가 발견되면 즉시 운영 문서와 정책의 적합성을 점검하고, 필요하면 거버넌스 정책을 업데이트합니다. 이처럼 프레임은 고정된 것이 아니라, 학습하고 진화하는 조직의 일부가 되어야 합니다.

샘플 역할 매핑과 RACI의 실무 예시

(프레임을 실제로 운용하기 위한 간단한 샘플 매핑입니다. 조직의 규모와 문화에 맞게 조정해 사용하세요.)

– AI 거버넌스 리더(Accountable): AI Governance Lead 혹은 CDAO

– 책임자(Responsible): ML Engineer, Data Engineer, IT Ops 담당자

– 협의된 자(Consulted): Legal/Compliance, Security, 데이터 소유 부문

– 통지 대상(Informed): 이사회, 주요 비즈니스 리더

참고로 이 구성은 결정을 내리는 주체를 명확히 하고, 각 단계의 산출물을 실제로 남길 수 있게 해줍니다. 예를 들어 모델 배포 전후의 로그, 데이터 흐름도, 평가 결과, 감사 기록은 모든 이해관계자에게 공유됩니다. 이와 같은 흐름은 고위험 영역에서 특히 중요합니다.

실행에 옮기기: 시작점과 실무 팁

- 가장 먼저 할 일은 높은 리스크를 가진 사용 사례를 식별하고, 해당 사례에 대한 책임 매핑과 실행 흐름을 문서화하는 것입니다.

- 모델 인벤토리와 데이터 흐름 맵을 만들고, 운영(runbook)을 작성합니다. 이때 ISO 42001의 관점에서 필요한 문서를 함께 정리합니다.

- 규제 방향성(EU AI Act 등)과 표준(ISO 42001, NIST RMF)을 내부 정책에 반영하되, 교과서적인 문서가 아니라 실제 의사결정에 연결되는 양식으로 다듬으세요.

- 작은 파일럿을 통해 프레임의 작동 여부를 확인하고, 피드백을 반영해 점진적으로 확장합니다.

질문 형식으로 독자에게 던져 보는 것도 좋습니다. 예를 들면: 당신의 조직에서 누가 최종 의사결정을 내리나요? 현재의 거버넌스 구조가 실제 운영과 얼마나 잘 맞물려 작동하고 있나요? 우리 조직의 다음 실행 단계는 무엇일까요?

이 글의 가치를 당신의 관점으로 읽기

나는 이 프레임이 “완벽한 답”을 주기보다, 당신이 실제로 대답을 찾아가도록 돕는 도구라고 생각합니다. 거버넌스는 도구일 뿐, 사람들의 협력과 학습이 없으면 의미가 없죠. 이 글을 읽고 바로 적용 가능한 작은 실천 하나를 떠올려 보세요. 예를 들어, 오늘 당장 할 수 있는 것은 무엇일까요? 데이터 품질에 대한 단 한 가지 체크리스트를 만들고, 모델 인벤토리의 첫 항목을 채워 보는 일일 수 있습니다.

마무리의 여운과 다음 단계

거버넌스는 끝나지 않는 여정입니다. 오늘의 설계가 내일의 도전에 맞춰 재설계될 수 있음을 인정하고, 계속해서 검증하고 개선하는 자세가 필요합니다. 그러한 여정을 함께 시작한다면, 우리 조직은 더 빠르고 신뢰할 수 있는 AI 운영을 달성할 수 있을 것입니다. 다음 글에서는 이 프레임을 실제 템플릿과 체크리스트로 구체화하고, 작은 기업에도 적용 가능한 실전 가이드를 제시하겠습니다.

참고 및 확장 정보: 최근 연구 및 표준 트렌드에 대한 구체적 출처는 McKinsey(2024), NIST의 AI RMF, ARIA 프로그램, ISO 42001, EU AI Act 등에서 확인할 수 있습니다. 필요한 경우 각 항목의 실무 예시와 템플릿을 더 자세히 다루는 Extended 글에서 구체적으로 제시하겠습니다.

질문으로 시작하는 AI 운영팀의 역할 매핑: 우리 조직의 거버넌스 여정

오늘의 고민은 아주 작고 구체한 한 가지에서 시작된다. 회의실 벽에 붙은 ‘AI 거버넌스 체크리스트’가 눈에 띈 순간, 나는 한 가지 물음에 머뭇거렸다. 이 기술이 비즈니스의 의사결정에 얼마나 깊숙이 관여하게 되었는가? 그리고 그 관여를 어떻게 책임의 맥으로 묶을 수 있는가? 이 글은 그 질문에서 출발해, 중소기업이 실제로 사용할 수 있는 화면 같은 프레임워크, 즉 AI 운영팀의 역할 매핑과 책임 정의 프레임워크를 탐구한다. 이 여정은 단순한 규정 준수가 아니라, 사람과 시스템이 함께 작동하는 생태계의 설계에 있다.

배경 왜 지금 AI 운영팀의 역할 매핑이 필요한가?

최근 몇 년간 AI는 더 이상 실험실의 실험이 아니다. 비즈니스 의사결정의 신뢰성, 법적 책임, 데이터 프라이버시와 보안을 둘러싼 이슈가 날로 커지면서, 거버넌스의 중요성은 전략의 한 축으로 자리매김했다. 글로벌 표준과 규제도 이를 따라잡고 있다. 예를 들어 NIST의 AI 위험 관리 프레임워크(AI RMF)와 ARIA 프로그램은 조직의 AI 리스크를 체계적으로 평가하고 관리하는 도구로 널리 채택되고 있다. ISO 42001은 “AI 관리 시스템(AIMS)” 구축의 글로벌 기준으로 주목받고 있다. EU의 AI Act는 고위험 AI 시스템에 대한 규제와 투명성 의무를 강화하고 있다. 이런 흐름 속에서 “누가, 어떤 결정에 의해, 언제”를 기록하고 공유하는 시스템은 더 이상 선택이 아니라 필수인 것이다. 이 맥락에서 AI 운영팀은 거버넌스의 실행력과 실행의 신뢰성을 동시에 담보하는 역할을 맡게 된다.

핵심 메시지 AI 운영팀의 네 가지 축

프레임은 네 축으로 구성된다. 각 축은 독립적으로 작동하는 것이 아니라 서로를 보완하며, 하나의 운영 모델로 엮인다. 아래의 축들은 모두 실무 산출물(로그, 인벤토리, 문서, runbook 등)로 직결되도록 설계되어 있다.

1) 거버넌스와 정책: 의사결정의 기록과 규칙화

- 무엇을, 누가, 언제 승인하고 기록하는지에 대한 명확한 규칙이 필요하다. RA(I) 거버넌스의 관점에서 역할과 책임의 경계를 정의하고, 정책은 실제 의사결정의 흐름과 로그로 남겨진다.

- 실무 산출물 예시: AI 시스템 목록화, 정책 문서화, 감사 로그의 표준화, 의사결정 기록의 체계화.

- 실무 포인트: 이사회 수준의 거버넌스와 운영 레벨의 실행 사이 다리 역할을 하는 문서 체계 수립이 핵심이다.

2) 리스크 관리 위험의 식별부터 감사까지의 체계

- NIST AI RMF와 ARIA를 바탕으로 위험을 체계적으로 식별하고 평가하며, 이를 비즈니스 의사결정에 연결한다. 고위험 영역의 평가 주기와 감사 포맷도 미리 정의한다.

- 실무 포인트: 위험 평가 양식, 모델 위험 관리 체크리스트, 컴플라이언스 맵(데이터 흐름과 처리의 투명성 확보).

3) 운영 관리: 데이터와 모델의 생애주기 관리

- ISO 42001의 가이드에 따라 데이터 흐름, 데이터 품질, 모델 문서화, 운영(runbook) 등을 연결한다. 데이터 소유자, 피처 엔지니어, 모델 개발자, 운영 엔지니어 간의 책임 분담이 구체화된다.

- 실무 포인트: 모델 인벤토리, 데이터 품질 지표, 모니터링 스펙, 로그·사고 후 학습 체계.

4) 실행/생태계 현장 운영과 협업의 실제

- IT 운영과 AI 운영의 융합은 이제 기본이다. Human-in-the-loop(HITL) 관점에서 언제 인간의 개입이 필요한지 정의하고, 자동화된 대응과 사고 대응 흐름을 설계한다.

- 실무 포인트: runbook, 사고 대응 절차, 공급망 관리 및 계약상 책임의 명시.

이 네 축은 하나의 그림을 그린다. 데이터 품질에 문제가 생겨도, 그 문제가 거버넌스의 정책과 연결되고, 모델 위험이 드러나면 기록과 감사로 남아 재설계의 자양분이 된다. 프레임은 고정된 규칙이 아니라, 학습하고 적응하는 조직의 일부여야 한다.

샘플: 역할 매핑과 RACI의 실무 예시

다음은 중소기업에서 바로 활용 가능한 간단한 샘플 매핑이다. 조직 규모와 문화에 맞춰 조정해 사용하라.

| 역할(Role) | 책임(R (Responsible)) | 승인(Accountable)) | 협의(Consulted) | 고지(Informed) |

|---|---|---|---|---|

| AI Governance Lead / CDAO | 거버넌스 프레임 설계와 실행 감독 | 최종 의사결정 책임 | 법무/컴플라이언스, 보안 | 이사회 및 주요 비즈니스 리더 |

| ML Engineer / Data Engineer | 데이터 파이프라인 구축, 모델 개발 및 운영 | 정책 준수 여부의 실행적 책임 | 데이터 소유자, 데이터 품질 팀 | 운영 현장과 IT 운영 팀 |

| Security / Compliance 담당자 | 보안 및 규제 준수 점검 | 정책의 준수 여부 최종 확인 | 법무, 데이터 소유 부문 | 이사회 및 감사인에게 보고 |

| 데이터 소유자 / 비즈니스 오너 | 데이터 품질 및 피처의 소유권 | 정책 적용의 실무적 책임 | ML/데이터 팀과 보안 | 이해관계자 전원 |

이 구조는 의사결정의 흐름을 분명히 하고, 각 단계의 산출물을 이해관계자와 공유하게 해준다. 예를 들어 모델 배포 전후의 로그, 데이터 흐름 맵, 평가 결과, 감사 기록이 모두 기록되고 공유되면, 고위험 영역에 대한 대응도 더 빠르고 정확하게 이뤄진다.

실행에 옮기기 시작점과 실무 팁

다음은 실제로 실행에 옮길 때 유용한 시작점이다. 작은 파일럿부터 시작해 점진적으로 확장하라.

- 가장 먼저 할 일: 위험이 큰 사용 사례를 식별하고, 해당 사례에 대한 책임 매핑과 실행 흐름을 문서화한다.

- 모델 인벤토리와 데이터 흐름 맵 만들기: 어떤 데이터가 어떤 모델에서 어떤 용도로 사용되는지 시각화한다. ISO 42001 관점에서 필요한 문서를 함께 정리한다.

- 규제 방향성과 표준의 반영: EU AI Act, ISO 42001, NIST RMF를 내부 정책에 반영하되, 교과서적 문서가 아닌 실제 의사결정에 연결되는 양식으로 다듬는다.

- 파일럿으로 시작하기: 작은 도메인이나 한 비즈니스 유닛에서 프레임의 작동 여부를 검증하고, 피드백을 반영해 점진적으로 확장한다.

- 성과 지표 정렬: 데이터 품질, 모델 위험, 컴플라이언스 준수 여부, 배포 속도 등을 KPI로 설정하고 추적한다.

질문 형식으로 독자에게 던지는 것도 좋은 방법이다. 예를 들어:

– 당신의 조직에서 누가 최종 의사결정을 내리나요? 현재의 거버넌스 구조가 실제 운영과 얼마나 잘 맞물려 작동하고 있나요?

– 다음 실행 단계는 무엇이고, 가장 큰 리스크는 무엇이라고 보나요?

독자와의 소통 우리 함께 생각하기

나는 이 프레임을 통해 완벽한 답을 주려 하기보다, 독자 여러분이 스스로의 답을 찾아갈 수 있게 돕고 싶다. 거버넌스는 도구일 뿐이며, 사람들의 협력과 학습이 없다면 무의미하다. 오늘 당장 실천할 수 있는 작은 시작 하나를 떠올려 보자. 예를 들어, 데이터 품질에 대한 단 한 가지 체크리스트를 만들어 보거나, 모델 인벤토리의 첫 항목을 채워 보는 것이다. 이제 당신의 차례다. 이제 직접 시도해보시기 바란다.

실무의 맥락 최신 동향과 실무 팁의 자연스러운 통합

- AI 거버넌스의 필요성은 기업 전략의 핵심으로 부상했다. RA(I) 거버넌스 도입과 전사 운영 모델 정비가 함께 진행되며 책임의 경계가 선명해지고 있다. McKinsey의 2024 연구도 이 흐름을 뒷받침한다. ISO 42001과 EU AI Act 등 국제 표준과 규제도 실무에 구체적으로 반영되고 있다.

- 운영 모델의 변화는 중앙집중형에서 분산/연계형으로의 전환으로 이어지고 있다. REAL–KPS 같은 프레임워크나, AI 운영모델 Playbook이 비즈니스 단위의 요구에 맞춘 권한과 생애주기 관리의 중요성을 강조한다. 이는 데이터 파이프라인과 모델의 수명주기가 비즈니스 가치 창출의 중심으로 이동한다는 신호다. 관련 정보는 NIST, ISO, EU의 문서들에서 확인할 수 있다.

- AIOps와 GenAI 시대의 도래는 운영 팀의 역할을 더 넓히고 있다. 사람-기계 협업과 HITL의 필요성은 점점 더 명확해지며, 프레임의 실행 가능성과 재현성을 높이는 방향으로 가고 있다.

마무리의 여운 다음 글에서 다룰 확장과 템플릿

이 글은 시작에 불과하다. 다음 글에서는 이 프레임을 실제 템플릿과 체크리스트로 구체화하고, 중소기업에도 적용 가능한 실전 가이드를 제시하겠다. 또한 각 항목의 실행 예시와 템플릿을 Extended 글에서 자세히 다룰 예정이다.

참고 및 확장 정보: 최근 연구 및 표준 트렌드에 대한 구체적 출처로 McKinsey(2024), NIST의 AI RMF, ARIA 프로그램, ISO 42001, EU AI Act를 참고하자. 필요 시 각 항목의 실무 예시와 템플릿을 더 자세히 다루는 확장 글에서 구체적으로 제시하겠다.

필요하신 경우, 이 글의 핵심 포인트를 바로 적용할 수 있는 체크리스트와 템플릿을 확장 글에서 제공합니다. 지금 바로 실행에 옮길 수 있는 한 가지 작은 실천으로 시작해 보시길 권합니다. 이제 직접 시도해보시기 바랍니다.

오늘의 결론은 간단하지만 깊습니다. AI 거버넌스는 더 이상 이념이 아니라 매일의 실행 규칙이 되어야 하며, 그것이 바로 신뢰와 속도를 동시에 확보하는 길이라는 점을 남겨둡니다. 이 글의 핵심은 네 축이 서로를 보완하며 하나의 운영 모델로 작동한다는 사실이고, 그 모델이 데이터의 말에 의사결정의 최종 책임을 부여하는 어떤 사람의 손에 의해 구체적인 행동으로 옮겨지도록 돕는다는 점입니다. 프레임은 고정된 설계도가 아니라, 조직의 학습과 적응 속에서 살아 움직이는 도구입니다. 이를 통해 데이터 품질의 문제도 모델 위험도 관리도, 결국은 비즈니스 목표와의 정렬로 수렴됩니다.

핵심 시사점

- 책임 경계의 명확화와 기록의 일관성은 의사결정의 속도와 리스크 관리의 질을 좌우한다. 누가 무엇을 언제 승인하고 기록하는지의 규칙이 바로 작동의 속도를 만들기 때문이다.

- 프레임은 하나의 고정된 규칙이 아니라, 조직의 상황에 맞춰 진화하는 도구다. 필요하면 정책과 로그의 흐름을 재정렬하고, 거버넌스의 실행력을 지속적으로 개선해 나가야 한다.

- 데이터와 모델의 생애주기를 비즈니스 가치에 연결하는 설계가 결국 경쟁력을 만든다. 수명주기가 길어질수록 관리의 정확성과 투명성이 더 큰 차이를 만든다.

- 거버넌스의 힘은 참여와 투명성에서 나온다. 이해관계자의 협력과 공유가 있을 때만, 프레임은 실제로 작동하고 신뢰를 얻는다.

실천 방안

- 고위험 사용 사례 식별 및 책임 매핑 문서화: 어떤 사례가 가장 큰 리스크를 내포하고 있는지 확인하고, 누가 최종 의사결정을 내리는지와 그 흐름을 기록하라.

- 모델 인벤토리와 데이터 흐름 맵 작성: 현재 조직이 다루는 데이터와 모델을 목록화하고, 데이터가 어떤 목적에서 어떻게 흐르는지 간단한 다이어그램으로 시각화하라. 데이터 소유자와 피처 엔지니어, 모델 개발자 간의 책임 경계를 초안으로 정리하라.

- 정책과 로그의 표준화: 최소한의 로그 포맷과 감사 기록의 시작점을 만들어 작은 파일럿을 설계하라. 거버넌스 문서가 실제 의사결정에 연결되도록 문서화하라.

- 파일럿 실행 및 피드백 루프 구축: 한 도메인이나 한 비즈니스 유닛에서 시작해 30일 단위로 피드백을 수집하고, 점진적으로 확장하라.

- KPI 정렬과 지속 개선: 데이터 품질 지표, 모델 위험 체크리스트, 규제 준수 여부, 배포 속도 등을 KPI로 삼아 추적하라.

마무리와 다음 발걸음

오늘 당장 첫 걸음을 시작해 보자. 학교처럼 완벽한 준비를 기다리기보다, 작은 시작이 신뢰를 만든다. 당신의 조직에서 누가 최종 의사결정을 내리는지, 그리고 첫 파일럿이 어떤 모습을 보였는지에 대해 한 번 생각해 보라. 이 여정은 결코 끝나지 않는 학습의 과정이다. 거버넌스는 도구일 뿐이며, 사람들의 협력과 지속적인 학습이 있어야만 진정한 가치를 만들어낸다.

다음 글에서는 이 프레임을 실제 템플릿과 체크리스트로 구체화하고, 중소기업에도 적용 가능한 실전 가이드를 제시하겠다. 확장 글에서 제시할 템플릿과 체크리스트를 기대해 주세요. 이 글이 시작점이 되어, 오늘의 한 걸음이 내일의 더 나은 의사결정으로 이어지길 바란다.

참고 및 확장 정보: 이 흐름은 거버넌스의 체계화 필요성에 대한 공감대를 바탕으로, 실무에 바로 적용 가능한 원칙으로 정리되었습니다. 필요 시 확장 글에서 구체적인 템플릿과 체크리스트를 제공하겠습니다.

- 오늘의 한 걸음이 곧 더 큰 신뢰로 연결되길 바랍니다.”} } ]}